AI PC成为马良的“神笔”,让NPC成为“赛博话唠” | 钛极客

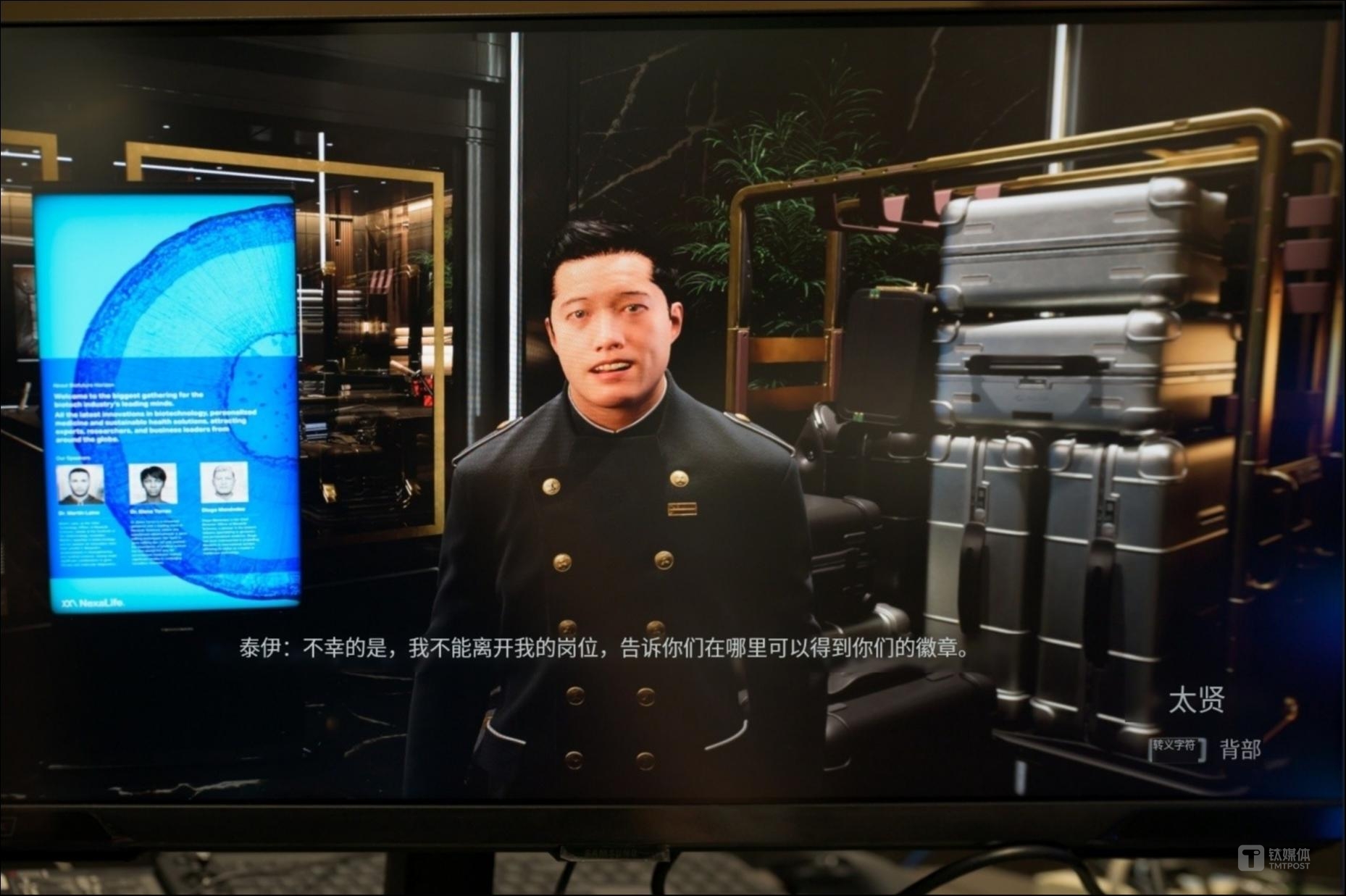

“我正在寻找马丁-莱恩先生,他告诉我正住在这间酒店,我有急事,请你帮我联系他,谢谢!”我说到。

“非常理解您焦急的心情,但是处于对酒店客人隐私的保护,我无法提供这位客人的信息给您,很抱歉。”前台服务员表示。

“我知道马丁-莱恩先生在这里寄存了东西,我是受到他委托来取走的,请你把它交给我吧。”我说到。

“好的,那您可以将行李寄存的寄存单给我吗?如果没有寄存单的话,可以让马丁-莱恩先生给礼宾部打电话,告知我们将东西给您。”

以上两段对话,听起来很像是摘取自某部小说或者是电影、游戏内容的固定台词,但它们竟然出自人与电脑的语音交流。

AI让游戏NPC“活”过来了

更准确地说,上述这些对话是玩家与游戏NPC的交流,只不过游戏流程中既没有固定逻辑脚本也没有预设提问、回答选项。玩家唯一要做的就是想尽办法与电脑“套话”获取信息。

电脑的目标则是确认玩家的身份确实与目标人物相关,在此之前,它们则要尽一切可能保守秘密。换句话说,这场对决其实是人脑与电脑间的“智力与信息的攻防游戏”,而驱动这台电脑的背后技术正是当下被所有行业集中讨论的“生成式AI”。

早在去年的COMPUTEX展会上,英伟达就推出了ACE(AvatarCloudEngine)技术,旨在通过生成式AI为游戏中的非玩家角色(NPC)带来智能对话和互动功能,如今大家看到的正是最新的DEMO演示。

与过去采用固定语句、动作与玩家交互的方式相比,利用NeMo语言模型,ACE可以创建能够进行自然语言对话的NPC。这些NPC不仅能理解玩家的输入,还能根据特定的背景和情境生成合适的回应,比如上文提到的各个角色会进行符合身份的回答,并且在称谓、回答内容上也会更加贴合真实场景。

对于ACE技术的出现,最大的意义在于可以帮助游戏内容制作者打破“线性”叙事的框架,也就是说,所有的游戏内容并不需要按照固定的内容流程完成。玩家可以充分发挥自己的想象,甚至可以颠倒任务的前后顺序,只要围绕最终目标即可,但这仅限于推理类的游戏,因为此类游戏中NPC的重要性更高。

那对于其他游戏而言,如果拥有开放式世界设定,也会在ACE技术上收益很大,因为每一位NPC都拥有了自身的“思维”而不是传统的固定逻辑,每天重复一样的事情。相比之下,过去的游戏就如同电影《楚门的世界》一样,只有玩家一个人可以尝试去灵活处置,而在ACE技术的加持下,玩家想出来的各种骚操作,电脑都有办法应对。

想象很美好,对吧?但就如同每次游戏画质的展示DEMO一样,回看2012年的虚幻4引擎展示,现在很多3A大作可能都还无法达到它的水平,ACE技术的应用也是如此,它的条件还是非常苛刻的,现阶段对线上同时在线的玩家数量、网络带宽等都有着严苛的要求。

据英伟达工作人员介绍,想要获得与NPC的实时沟通体验,专线网络是必备选项,同时在线的玩家数量也要控制在个位数,这对于一款商业游戏而言,是完全不可接受的。

那想要扩大玩家接入量,对于游戏开发商而言,就需要更强的云端算力作为支撑,但在整个游戏内容的制作过程中,是否应该为NPC配置如此重量的资源以及它能够带给玩家的反馈提升,都是现阶段面临的问题。所以说,ACE技术确实展现出了一个能够让游戏NPC“活”过来的办法。

AIPC成为数字时代的“神笔”

“神笔马良”是很多人都听过的中国童话故事,马良在获得神笔后,能够把自己的画作变成真正的物件。而在AI时代,PC反而成为了“神笔”的化身。一方面,StableDiffusion等工具可以将文字表述变成图像,这样就可以将脑中的构想通过最简单的方式呈现为画作,即便是没有绘画天赋的人也可以做到。

以英伟达目前的消费级旗舰产品RTX4090D为例,作为市面上最快的StableDiffusion计算出图方案,它可以支持每秒8张图的生成速度。使用当前最快的StableDiffusion加速方法TensorRT,再配合开发者进一步的性能优化,目前RTX4090DGPU最高能实现每秒超过100张图的生成速度。

这是什么概念呢?路边的肖像速写,应该是日常能够接触到的比较快速的绘画出图方式,而画成一幅人像作品的时间,通常在10分钟左右。在同样时间内,StableDiffusion生成的图片数量(以每秒8张计算),已经足够支持组合为每秒30帧的视频播放两分半钟,而图片数量则是整整的4800张。

当然,AIPC的能力不仅仅体现在文生图上。图生图的应用也很有趣,比如通过人像生成控制模型InstantID,就快速通过搭载RTX4090D的RTXAIPC上由普通摄像头的自拍照生成高质量影棚级别的肖像照,别的场景不说,至少笔者认为对很多以拍证件照作为主要盈利手段的小摄像馆来说,这项功能绝对是“抢饭碗”的利器。

应该说,更快的生图速度、更广泛的生图应用,其实也没有什么稀奇的,毕竟不是每一张图片都能符合预期。而且玩过AI生图的人都知道,生成的图片质量参差不齐,总是需要不断修改、不断尝试才能获得基本满意的效果,而绘画则不同,往往在起笔时就已经有了大概方向,途中也可以进行小范围的调整。

但钛媒体APP认为,AI生图应用出现,最大改变在于把绘画的门槛降低了,同时也进一步解放了人们脑中的万千创意,像“科幻元素“的作品,大众普遍能够输出的目前只包括文字部分,你可以把天马行空的想法“写”下来。

文字表述自然有其任凭读者想象优势,但在直观性上也恰恰受到了限制。因此很多科幻小说作品,比如《三体》《沙丘》等等,文字的描写在精妙,也会有很多超出读者想象的画面,而将这些作品影视化改编,其所付出的成本却又高的离谱,那么,通过AI绘图,是不是刘慈欣就可以简单描绘一下他心中的《三体》了呢?这是很有可能的。

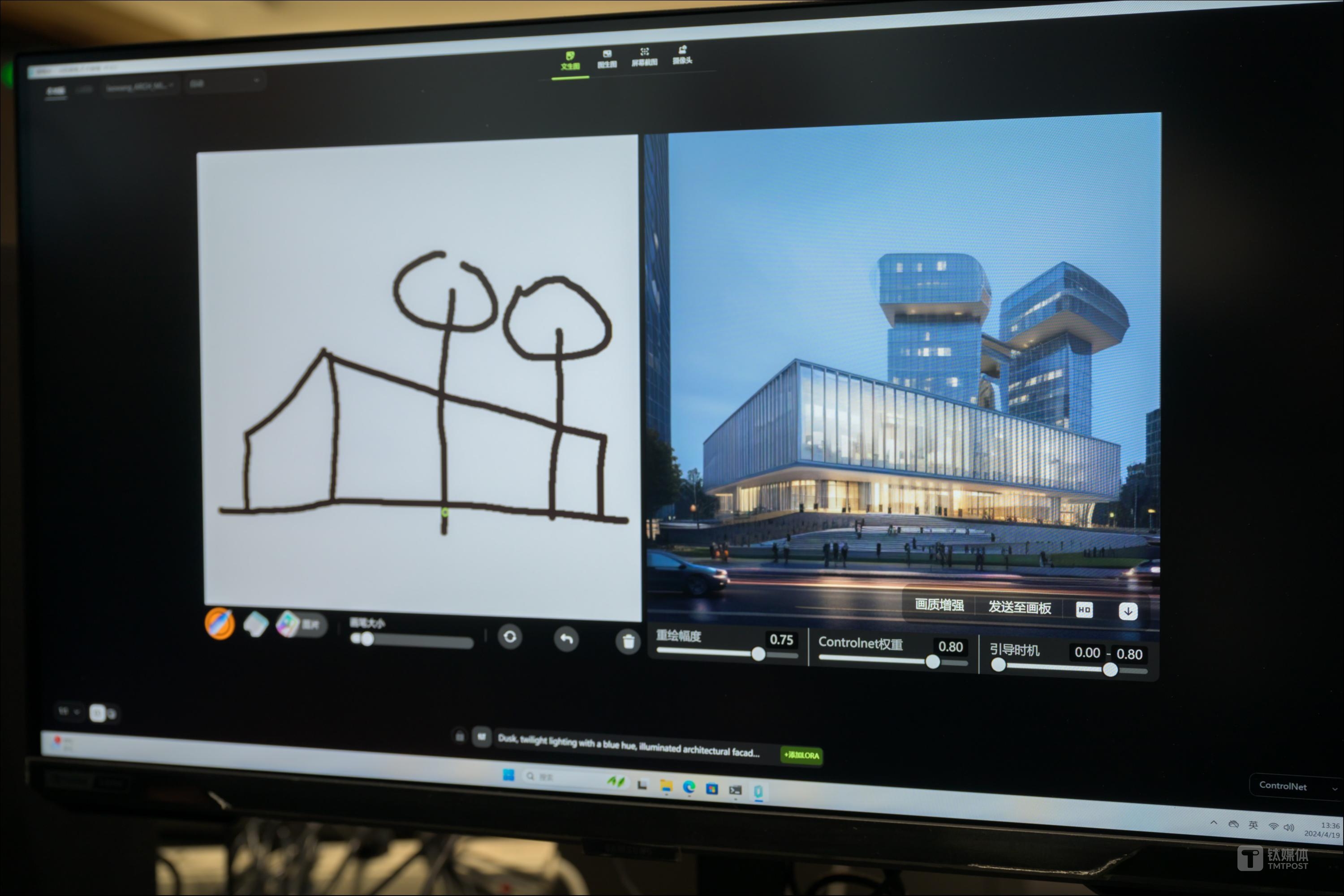

其实,当前已经有很多设计师、艺术家,设法将生成式AI提供的“想法落地为现实”能力转变为自身的生产力。

像在建筑设计领域,即时AI基于扩散模型和蒸馏技术,通过RTXGPU的加速,实现了AI实时绘画,屏幕前的设计师只需要勾勒出简单的线条,AI就能帮助根据目标风格绘制出具体的概念图,设计师可以花更多时间集中在想法上,而不是如何把一个有趣的想法,一笔一笔“画”出来。

所以说,AIPC的生产力属性,真的在绘画这件事上表现的淋漓尽致。一方面,它确实大大降低了绘画的门槛,无需掌握具体的绘画手法、色彩选择,这些都由AI完成,人们只需要专注于“想法”。

另一方面,其在行业中的渗透和落地应用潜力也是更加直接的,ChatGPT也许什么都能干,但通过它,很难直接创造商业价值,但对于艺术家、设计师来说,提升几十上百倍的出图效率和“想法预览”确实能够直接转化为生产力。

视频会议、游戏场景,AIPC无处不在

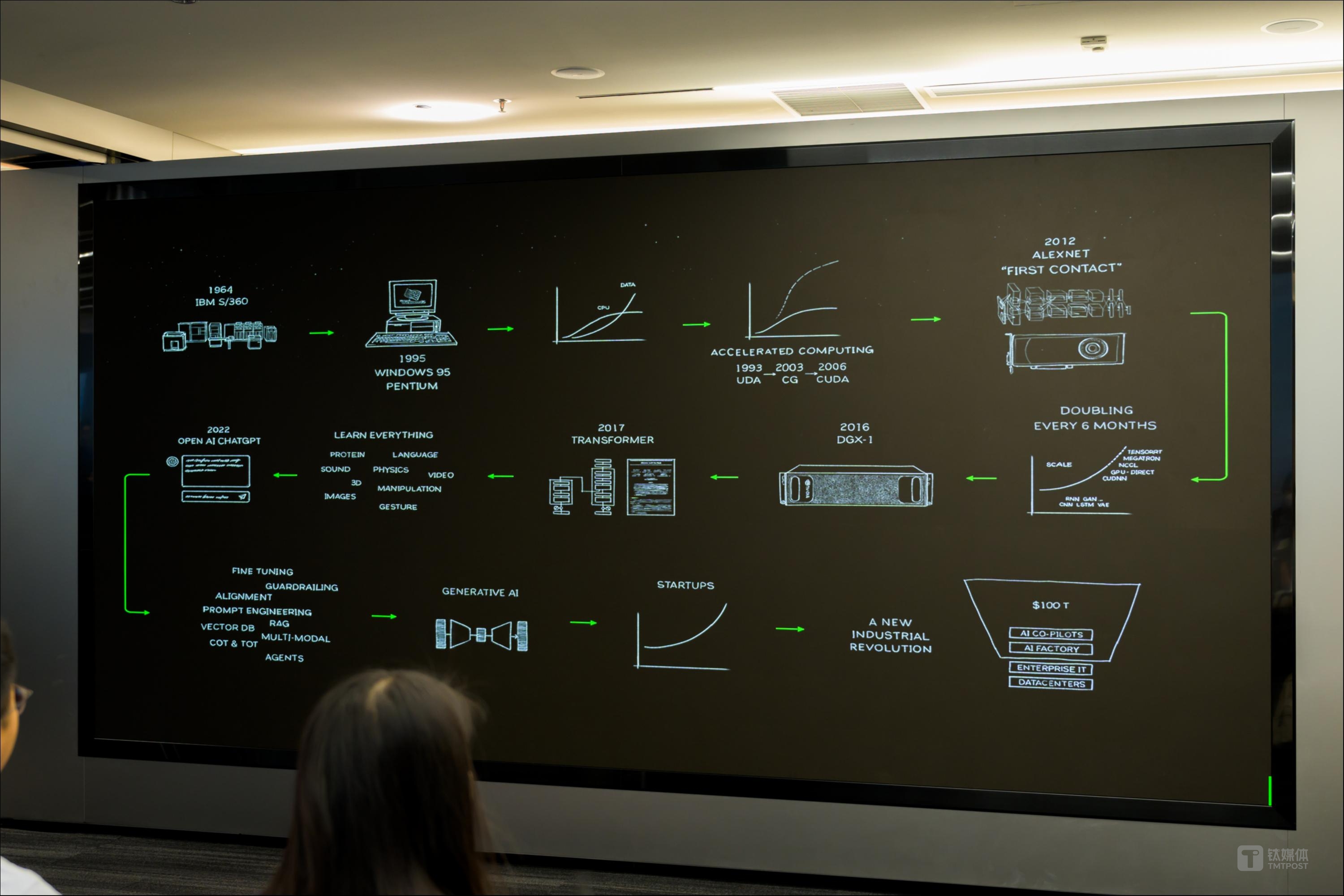

很有意思的一点是,目前行业内对AIPC的定义也有着不小的分歧,如果按照英特尔的说法,2023年底AIPC才出现,2024年是AIPC元年,而对于微软、高通来说,似乎AIPC又是2024年刚刚推出的新物种。

但如果要追溯到更早,实际上英伟达于2018年就推出了RTX技术和首款专为AI打造的消费级GPU芯片(GeForceRTX)。在他们看来,AIPC是搭载专用AI加速硬件的计算机,而在RTXGPU上,这些专用的AI加速器被称为TensorCore。

TensorCore的出现,实际上就是为了能够加速AI性能,并为PC用户引入以前在云端才能运行的AI新功能。针对开发者或者深度AI用户,英伟达也已经上线了TensorRT开发者套件,实现加速深度学习推理性能。

TensorRT能加速热门的生成式AI模型,StableDiffusion1.5和SDXL等,全新的ULProcyonAI图像生成基准测试也已支持TensorRT加速。

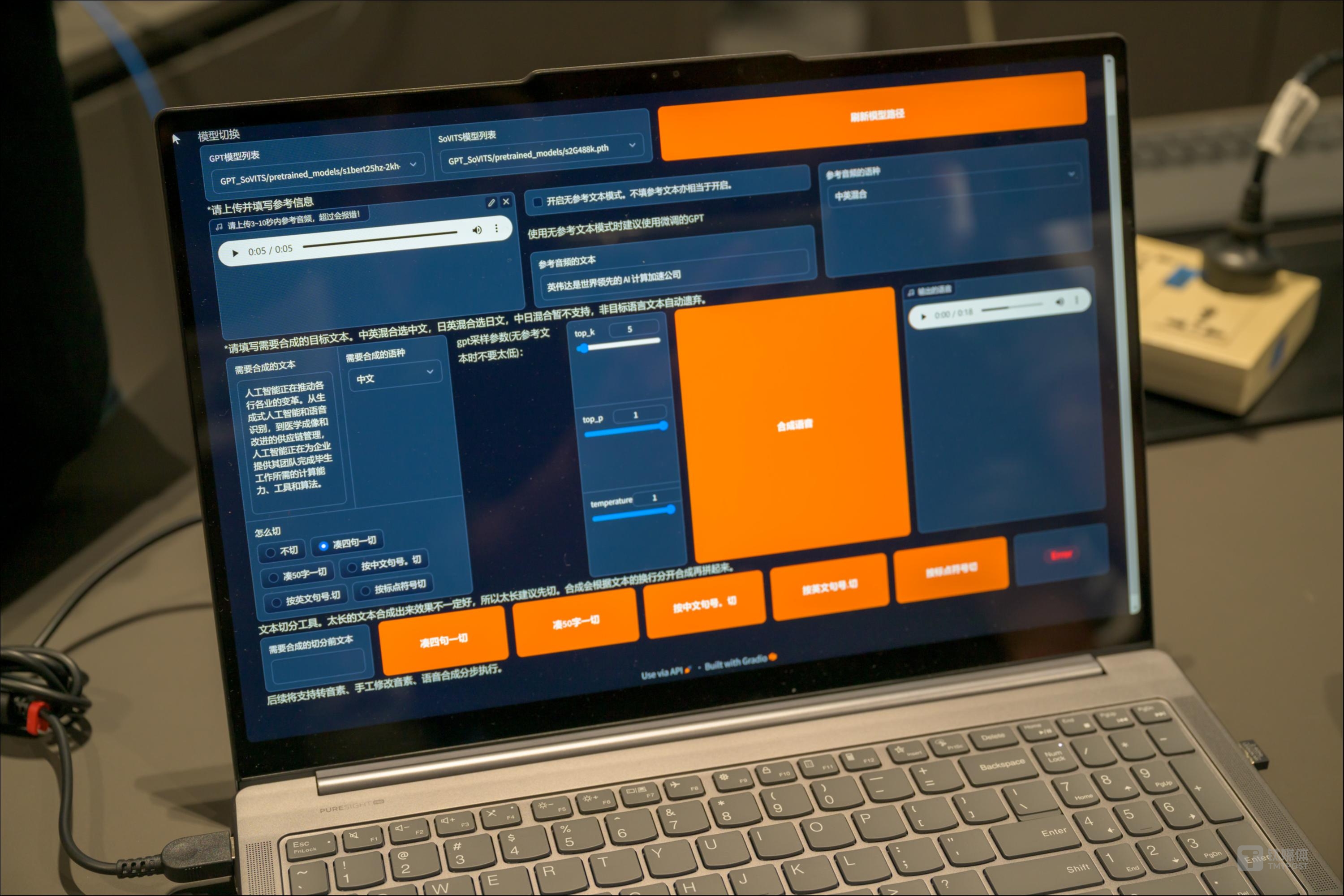

AI能力除了可以用在提升游戏开发、生产力上,它还能做很多工作,当你觉得用自拍生成棚拍画面已经足够离谱,那么1分钟语音就能克隆声音的AI能力,是不是会感觉AI会有点“恐怖”?

基于RTXGPU加速的声音克隆可仅用5秒录音来克隆声音,实现无需训练的个性化声音生成。基于开源的GPT-SoVITS项目,声音克隆快速使用5秒声音样本,根据其发音特征由文本生成个性化语音片段,这个过程仅五分钟就能完成,而基于更多样本(1分钟)的微调训练则能实现更高质量接近1:1复刻的声音克隆。

作为消费级GPU产品的供应商之一,英伟达看中AIPC的其中一个落地场景当然是“游戏”,并为此推出了DLSS图形技术,其原理就是利用AI提高帧率并改善图像质量。最新的DLSS3.5技术中,可以通过AI增强光线追踪表现,备受期待的《黑神话:悟空》和《永劫无间》即将支持DLSS3.5光线重建和全景光线追踪技术。

换句话说,就是让显卡能够以更低的负载,输出更高帧率的画面以及光影质量更加逼真的内容,而这一切并不是通过传统意义上增加图形算力获得的,而是通过AI能力获得的。此外还有RTXRemix技术,通过使用生成式AI工具自动增强材质,以及借助全景光线追踪和DLSS快速创建画质更好的“重制版”游戏。

其他一些方面,AI的应用也在加速渗透当中。比如很早前就已经上线的NVIDIABroadcast应用,可以为直播提供AI增强型语音、视频工具,包括噪音和回音消除、虚拟背景和AI绿幕、面部追踪、视频降噪和目光接触,其实很多主播目前都已经开始使用了,本地算力调取不占网络带宽和低延迟是它最大的优势。

如果讨论生成式AI所能玩出的花样和上限,英伟达无疑是现阶段最有发言权的厂商,无论是已经看到的各类应用还是各个AI公司疯抢的高算力GPU,都能代表其在AI领域硬件方面的领先地位,但想要把AIPC普及起来,或者让普通消费者为AI功能而添置或升级GPU,现阶段而言并不现实。

可以预见的是,AIPC在各行各业的应用会越来越广泛。同时其对娱乐、办公、社交等场景的渗透也会慢慢深入,但与很多此前发布的技术不同,生成式AI的加入往往是“无感”的,比如StableDiffusion绘画出的高质量图片往往能够以假乱真,而ACE技术加持下的NPC也与真人有几分相似,更不要说AI还能帮助实现声音克隆等能力。